美光第二代HBM3产品助力AI语言模型训练时间缩短30%

7月28日消息,美光科技股份有限公司今日发布了一项重要消息。据悉,该公司已开始提供业界首款8层堆叠的24GB容量第二代HBM3内存,其带宽高达1.2TB/s,引脚速率超过9.2Gb/s,性能较市面上现有HBM3解决方案提升最高50%。这一新产品创下了关键型人工智能(AI)数据中心性能、容量和能效指标的新纪录,预计将在AI领域发挥巨大作用。

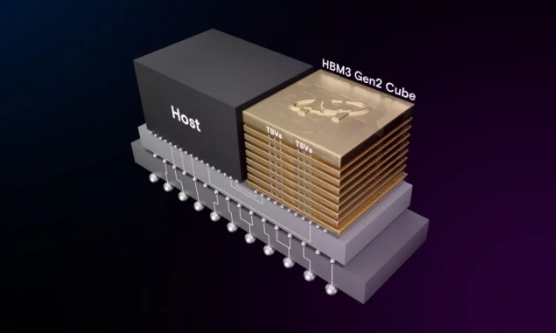

据了解,美光的第二代HBM3产品在与前一代相比,每瓦性能提高了2.5倍,为AI数据中心的极端功耗需求提供了有效的解决方案。为实现能效的显著提升,美光在技术上进行了革新,如将硅通孔(TSV)数量翻倍,增加金属密度以降低热阻,并设计了更为节能的数据通路。这些举措使得美光第二代HBM3内存成为满足生成式AI领域多模态、数万亿参数AI模型日益增长需求的理想选择。

据了解,这款高性能内存将为大型语言模型的训练时间缩短30%以上,从而有效降低总体拥有成本。除此之外,美光第二代HBM3内存还将带来每日查询量的显著增加,更有效地利用训练过的模型,进一步提升AI数据中心的运营效率。在已经部署的1000万个图形处理器(GPU)用例中,单个HBM模块可节约5瓦功耗,为客户节省高达5.5亿美元的运营费用。

作为计算与网络领域的领导厂商,美光与台积电3DFabric联盟展开合作,共同构建半导体和系统创新的未来。在第二代HBM3产品开发过程中,美光与台积电密切合作,为AI及高性能计算(HPC)设计应用中的顺利引入和集成计算系统奠定了基础。目前,台积电已收到美光第二代HBM3内存样片,正在进行下一步的评估和测试,预计将助力客户的下一代高性能计算应用创新。

美光副总裁暨计算与网络事业部计算产品事业群总经理Praveen Vaidyanathan表示:“美光第二代HBM3解决方案旨在为客户及业界提供卓越的人工智能和高性能计算解决方案。我们的一个重要考量标准是,该产品在客户平台上是否易于集成。美光HBM3具有完全可编程的内存内建自测试(MBIST)功能,可在完整规格的引脚速度下运行,使美光能为客户提供更强大的测试能力,实现高效协作,助力客户缩短产品上市时间。”

英伟达超大规模和高性能计算副总裁Ian Buck也对美光的技术创新表示期待:“生成式AI的核心是加速计算,HBM的高带宽至关重要,并带来更出色的能效。我们与美光在众多产品领域保持了长期合作,非常期待与美光在第二代HBM3产品上继续合作,加速AI创新。”

美光的第二代HBM3产品展现了公司在AI服务器领域的前沿技术创新。此前,美光已推出基于1α(1-alpha)节点、24Gb单块DRAM裸片的96GB容量DDR5模组用于大容量服务器解决方案;如今推出基于1β节点、24Gb单块DRAM裸片的24GB容量HBM3产品,并计划于2024年上半年推出基于1β节点、32Gb单块DRAM裸片的128GB容量DDR5模组。这些产品的推出将为AI领域带来更多的可能性和机遇。